最終更新日 2024/3/31

2020~2022年度(※延長で2023年度まで) 科研(挑戦的萌芽)「言語から見た日米マインドスケープ比較:データサイエンス志向型小説研究の試行」(20K20699)

◎このエントリの位置付け

本エントリは,報告書「科学研究における健全性の向上について」(日本学術会議,2015年3月6日)の(2)-1および(2)-5アで指摘されている「研究ノート」の電子版として位置付けています。その都度の準備の状況・実験の過程・問題点などを時系列的に記録し,誤記の修正などを除き,過去の内容は変更しないこととします。

◎事業目的(科研申請時)

米語コーパスの原型とされるBrown Corpusの「小説セクション」のサンプリング基準を日本語に適用し,Brownと比較可能な日本語均衡小説コーパスを構築した上で,日米小説データの言語分析に基づく計量的マインドスケープ比較を試行する。

◎これまでの進捗(概要)

(2020年度)

7月 採択決定

8~9月 採択にかかる諸手続きなど

10~3月 研究手法の検討,Brown Corpus収録の小説作品の調査

(2021年度)

4月 本年度のスケジューリング

5月 大学図書館蔵書調査,収集対象決定,資料収集,文字化作業着手

6月 英語4コーパスの小説の整形+日本語化,日本語小説3年分のテキスト化,英語化

7月 日本語小説のテキスト化,英語化,形態素解析を進める

8月 検索システムの開発準備(業者打ち合わせ),英語POSデータ作成,出版社への告知

9月 検索システム開発契約,JAECS発表準備

10月 学会発表,検索システム開発継続

11月 検索システム開発継続

12月 検索システム用ウェブサイト開発,出版社に説明文書発送。

1月 検索システムの改修

2月 検索システムの公開,論文執筆,研究発表

(2022年度)

4~10月 論文執筆準備

11月 タグ付けの修正作業の検討(発注は2023以降)

12月 オンラインインタフェースのJASWRICとの共通化検討

1月 品詞タグ付け検証作業の見積もり依頼と発注

2月 1961データ検証作業

3月 1971データ検証作業

(2023年度)

4~8月 1981~2021データ検証作業

11月 日英語対応語彙表自動作成システムの構想と見積もり取得・発注

11月 更新後データによる差し替え業務の依頼

1月 更新後データについて作業指示ビデオを作成・送信

3月 データ更新作業完了、語彙表システム納品

2023年度の業務の記録========================================

JFICデータ更新作業経緯

1/13 ビデオで作業方針説明

1/25 ビデオ再送付の依頼あり

3/1 更新作業完了通知

・「品詞」が空のデータが数件ある

・「語彙素読み」は画面上で表示箇所がないため、今回は未使用

・「文境界」を以前はsentence区切りに使用していたが今回はデーターがなかったため、「。」をsentence区切りとして使用

3/2 検証の結果数字が合わないので連絡

3/18 本システムへの新規データ反映完了。納品処理。

========================================

複数ファイルからの統合語彙表自動作成システム開発記録

2023

5/23 A社に見積もり依頼

6/21 予算オーバーのため交渉を打ち切り

<開発の方向について検討>

11/6 B社に見積もり依頼

11/7 受託可との返答

11/8 日本語だけでなく英語の処理も統合したシステムとして発注

11/9 仕様書策定

11/20 口座登録など事務手続き完了

12/24 第1次モデルの完成

12/25 不具合発生

2024

1/10 対応完了

1/10 不具合解決せずビデオにて問題を説明

1/12 微修正後に再検証するが不具合が残りビデオにて問題を説明

1/22 修正対応、作業ビデオ作製

1/25 再修正

1/31 インタフェースの文言を作成して送付

2/5 対応完了

2/7 英語処理時のエクセルのトップシートへの情報記載の依頼

2/14 英語処理時のエラー報告

2/15 対応完了、行列転換処理の決定

2/19 英語のcase sensitive/insensitiveの切り替えを実装

2/21 大幅修正

-- 英語において単語以外を削除(ここで言う「単語」とは、a-z を最低1文字含む文字列)

-- ファイルごと、単語ごとの頻度、及び総頻度を集計、表示

-- 「レンジ数」の集計(出力では「ファイル頻度」と表記しました)

-- 全ファイルの合計単語の降順にソート(この結果シートごとに違う

-- その他(列幅の調整、列の固定化などを地味に改良)

2/22 当方指示

1)日本語の場合も、タグで補助記号となるものは結果から排除してほしい

2)日本語に、謎の空白?が出ているので、これも出ないようにしてほしい

3)その他文言修正依頼

2/26 対応完了

2/28 会計上の納品処理

3/10 出力ファイルがコード順に並ばない問題を通知

3/16 検証後出てきた問題を連絡("part"と"part-"、"to"と"to."と"to-"が別語扱い、同じ語が別エントリに入っているものがある、myなどレマ化されていないものがある、数があわないものがある

3/18 対応通知あり、数字と記号をスペース扱いにするよう依頼

3/19 対応あり、アラビア数字を外す処理依頼

3/20 英語コーパス学会ESP-SIGでお披露目発表

3/21 日本語の「~」が単語認定されている件の修正を依頼

3/24 語彙素の犬、いぬ、イヌがまとまっていない問題の修正を依頼

3/25 対応通知

~以後の修正などは、継続科研である基盤B(WE22科研)で対応~

==========================================

◎プロジェクトの作業指針と概要(2021年12月更新)

<日本語モジュール(メインモジュール)構築>

(1) サンプリング方針

・日本の主要文芸誌3種を母集団とし,Brown Corpusの資料収集年次である1961年を起点として,10年ごとに文芸誌掲載の小説テキストを収集する

・データを取るのは対象年次の1月号とする(ただし神戸大図書館に欠本の場合に限って,2~3月で代替する)

・3雑誌あわせ,対象年次ごとにとる作品数は,Brown Corpusの小説(general)のサンプル数(29)を参考にして,31を基準とする(※+2とするのは問題があった場合に後で削れるように)

・ジャンルはBrownで言う「K:一般(general fiction)」とし,内容分類は行わない

・長編・短編の数の意図的なコントロールは行わないが,各号には,読み切り中編・短編のほか,長編連載の一部などが掲載されるため,母集団に対して自然な分布となる。

・文学評論・座談会・短報などは取らないが,日本の私小説の伝統もふまえ,5000字を超える文学的エッセイは対象に含める

・1テキストは5000字(※Brownは英文2000語)を原則とし,文の途中で会ってもそこで打ち切る。字数はエディタ「秀丸」による(全角空白を含める)。

・ただし,(a)(年次ごとの規定のサンプル数を満たす上で必要な場合は)4,000字以上のものを(全体の10%未満まで)含める,(b)5,000字で作業後,コピー時の読み取り不良個所(ページの中央近傍)を補綴することで5,000字を若干超えるものが出ることは許容する

・収集したデータはDeepLとみんなの自動翻訳でAIによる英訳にかけ,英語からも検索できるようにする。AI翻訳の内容は手作業で修正しない。

(2) 収録サンプル数(2021年8月17日現在)

___________________________________________________

年号 文學界(BG) 群像(GZ) 新潮(SN) 合計

____________________________________________________

1961 8 10 13 31 (済)

1971 10 11 10 31 (済)

1981 12 8 11 31 (済)

1991 11 10 10 31 (済)

2001 8 15 8 31 (済)

2011 13 7 11 31 (済)

2021 8 8 15 31 (済)

____________________________________________________

合計 70 69 78 217 ____________________________________________________

・1991-SNの英語原作翻訳はデータからカット(7/8付け)

・1971-SNは3月号からデータ取得(1月欠本,2月三島特集)

・2001-BGは1月号から4本,2月号から4本

(3) 日本語小説の書き起こしにかかる処理ルール(2021/7現在)

______________________________________________

・テキストは1作品ごとにファイルを分けて入力

・ファイル名はPDF内記載のコードで入力

・文字数はカット記号の★込みで全ファイル5,000字で統一

・文字コードはUTF-8で入力

・題名・作者名などは省略

・段落頭のアキは原稿通り

・文章段落頭以外の小見出し、番号、字下げ箇所、地付き文字などはすべて詰めて入力

・空行(空改行)は1行分のみ入力

・括弧記号は全角で入力

・アルファベット略号は全角で入力

・横書きの欧文は半角で入力

・算用数字は1桁を全角、2桁以上を半角で入力

・旧かな・旧漢字は新字体で打ち直して入力

・打ち直しの判断に迷った箇所は原稿通り入力

・くの字点・踊り字「ゞゝヾヽ」はひらがな・かたかなで入力

・一部の環境依存文字、旧字体・正字、Unicode文字は新字体・拡張新字体で入力(例:躯、掴、など)

・単独で判読できない文字は■(黒四角)で代用

・ノドの黒い部分で判読できない行、途切れている行は前後に1行あけて★印を行数分入力

_________________________________________________

<日英対照研究用英語小説モジュール(当面非公開)>

・LOB/Brown/FLOB/FROWN/CLOB/CROWNの小説(general)を収集

・タグを抜いてプレーンテキスト化,日本語化

・日本語モジュールとの対応上,足りない部分は今後埋めていくことを予定

____________________________________________________

年号 国 元コーパス サンプル数 日本語訳作成

____________________________________________________

1961 US Brown 29 済

1961 UK LOB 29 済

1992 US Frown 29 済

1991 UK FLOB 29 済

2009 US CROWN 29 未

2009 UK CLOB 29 未

________________________________

・北京外大で構築されたCLOB/ CROWNは,2021/7現在,DLができなくなっている(CQP Webでのみ公開されている)

・過去に石川研究室で保存していたデータをモジュールに仮に編入(※製作者と権利関係の相談を予定)

◎月次報告

(2023年4~8月)

4/3 1971検証終了報告

4/26 1981検証終了報告

5/31 1991検証終了報告

6/5 2001検証終了報告

6/29 2011検証終了報告

8/3 2021検証終了報告と、ファイルマージ依頼。→マージ処理+形態素列でのソートをこちらで作業して作業者に返送。最終検討(同一形態素への別品詞割り振りがないかのチェック)の依頼

(2023年3月)

3/6 作業者より1961検証データの仮納品

3/17 研究期間の延長の承認あり

3/19 作業者より1971検証データが納品、当方で確認の上、会計処理に回す

(2023年2月)

2/2 トライアルデータへのフィードバックをまとめ、作業手順説明ビデオを作り、作業者に連絡

2/8 上記確認着信と、新スケジュールの連絡あり

2/28 作業者より1961検証データの中間報告あり、チェックしてOKだし

1/23 タグ付け検証の見積もりが到着

1/23 今年度分として1961/1971の検証を依頼

1/24 会計打ち合わせ、システム入力、科研プロジェクトの延長申請、検索システムの修正のための現在インタフェースの確認

1/25 インタフェース日本語化と修正指示を送付

1/26 インタフェース修正案受領

1/27 同上フィードバック送信

1/31 上記について確認。行コードの追加など。作業者とメールをやりとりし、細かい仕様を固めていく、web茶まめ優先、を基本方針として。

(2022年12月)

12/10 インタフェースの改修について見積もり作成依頼

(2022年11月)

11/14 国立国語研究所にタグ付け修正作業者の紹介依頼

(2022年3-10月)

論文執筆準備、タグ付け修正方法の検討

(2022年2月)

・2/1 業者より1/26の当方依頼と照会についての対応報告。

・2/9 記号タグ付けのエラー個所を特定。」――という文字列がなぜか名詞に登録されていた。そのほか統合トップを作成。業者に作業継続を依頼。

・2/16 JFICを紹介する論文を執筆。終助詞をテーマに。

・2/17 論文ほぼ完成。

・2/18 業者と連絡。検索システムの本番サイトでの駆動を確認。研究会用に検索システムの使用ガイドを作成。その過程で,ウェブサイトの誤記を発見し修正。

※「|」はデータのセパレータだが,検索ボックスに入れる際にはORの意味となる。

※コロケーションは半角スペースで。

・2/20 学習者コーパス研究会で発表。JFICを紹介。

(2022年1月)

・1/8 出版社からの異議申し立て期限(1/7)が経過したため作業を再開

・1/9-10 Guideページの修訂,日本語での検索のやり方をしめす注記を新規に作成

・1/12 業者より対応返信。ほぼすべて解決。残った問題点を同日中に返信。

・1/14 業者との調整でPMWのズレの原因になっていたWordlistでの記号のカウント問題が解消。記号について形態素解析誤解析によるものと判明。調整の結果1月~2月10日にかけて本番環境に移行することに。

(12月)

・12/7 業者より定時の進捗報告

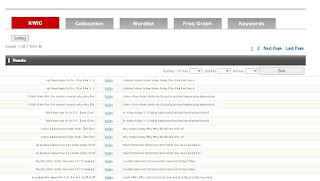

・Freq Graph/ Keywordの調整完了

・Keywordの指定画面の調整

・POSに関する説明や機能の実装

・処理速度はスペックの高い本番への移行(リリース)後に再確認

・12/15 挙動検証・業者にフィードバック送信,ウェブページ作成着手

★フィードバック項目

0)全体に追加するアイコンボタン:Guide Works Copyright

1)全体の修正

×Subaru → 〇Shincho

×Year of Publication → 〇Year/ Source

×Texts to be analyzed → 〇Text

×English Trans (DeepLR) → 〇English Trans 1 (DeepLR)

×English Trans (NICT) → 〇English Trans 2 (NICT)

×1961(S36)など年号すべて →〇 1961 (S36) (※半角空白を入れる)

×Data Sources→〇Source (Dataとる,単数形)

※画面の一番下のCopiright 2015- → 2022-

2)各画面デザインの修正

KWIC/ Collocation

・Caseの列を追加(Wordlist画面同様英語の場合以外は選択できないようにしておく)

Collocation

・デフォで全選択に

Wordlist

・Numberの20の部分に上下センタリングかける(他の画面と同じく,画面を小さくしても行の中央に配置されるように)

・デフォでは全選択に

Freq Graph

・ComparisonをYear/ Sourceに変更

・Year/ Dataの選択ボタンは取る(要確認)

1行目 Source (デフォルトは全選択)

2行目 Year (デフォルトは全選択)※または左右配置でも可

Keywords

・Targetの左セルをその下のセルと結合。Targetと同じ行の左にYear/ Sourceが入る

3)機能別

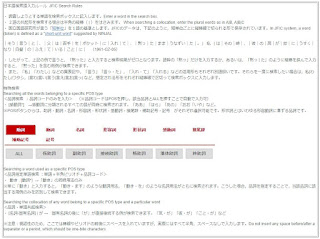

A)KWIC 日本語の検索対象指定方法

=================================

本 "本"

今日|昨日 "今日" and "昨日"

本.[名詞*] "本" (名詞*)

その [名詞*] を "その なか を"/ "その 手 を"/ "その 本 を" etc

私|僕 [名詞*] は "僕 今日 は"/ "私 自身 は"/ "僕 自身 は" etc

==================================

・「今日」と「きょう」と「キョウ」を同時に出すには? (語は同じで表記形がいろいろ)

・「私」と「わたし」と「ワタシ」を同時に出すには?(同上)

・「私」と「わたし」と「ワタシ」と「俺」と「おれ」と「我」と・・・・を同時に出すには?(形態素)

・名詞全部を出すには?

・POSボタンを押しても[ ]が出ないがこれは手で入れる仕様?

・本.[名詞*] の意味は,名詞の本を探すということ??

B)コロケーション

・デフォルトで何かが出てくるがそれがどの統計値の結果かわからない(デフォでも色をつける?)

・統計値を切り替えたとき,ボタンの色がすぐ変わるようにできないか?(現状,全体結果が再表示されるまで長い時間がかかるが,統計値のボタンの色の切り替えが起こらないので押せていないのではと何度も押す羽目になる)

・依然として時間がかかる

・tスコアの計算は正しいか?(マイナスが出る)

例 61の3冊のみ指定 「今日」で検索 「に」頻度1,統計量-0.10??

・英語の場合,コロケーションで出てくるターゲット語の頻度がKWICの結果とあわない

例 61の3冊のみ指定。DeepL指定。「today」はKWICでは全22例。コロケーションでは全24例。(大文字扱いのズレ? Caseの行をそれぞれに入れることで解決?)

※日本語でやると「今日」はどちらも29例ずつでそろう

C)単語リスト

・「、」「。」「「」」「ー」「空白」などが語としてカウントされているが,記号類・空白は排除。※PMW処理時の総語数への影響を考慮 (英語だとピリオドや記号は出ない)

D)頻度グラフ

・頻度はPMWと書いているが実際にはPMWになっていないのでは?

E)特徴語

・たとえば1961年vs全年代で比較しようとすると「It overlaps with the reference origin referrinh ahead」という注記が出るが,これは問題ないので可能にするように。(部分vs部分,部分vs全体,どちらの比較もOK)

・12/16 業者より返信。POSタグの[ ]自動挿入はICNALE含めて対応することに。当方より,追加で,KWIC出力画面他で,キーワードおよび隣接語の境界記号を入れるよう依頼。例:友達|と|小 学校 に |行く| → |友達|と|小| 学校 |に|行く|。昨日作成のウェブサイト,画像が出ない問題を確認。解決方法を模索中。

・12/18 出版社用の検索システム説明文書を作成。各社に事前確認依頼のため発送。何かあれば1/7までに連絡を依頼。

・その後,ウェブサイト(解説の飛び先)の作成。いちおう公開にこぎつける。

・12/16 追加依頼(キーワードの| |単語区切りの不揃い修正)

・12/23 追加依頼(新規作成guideへのリンク先の誘導の依頼)

・12/24 業者からの対応レポート届く,支払い関係の調整

(11月)

・11/5 月次進捗報告確認。データベースの格納まで終了

・11/6 keyword検索時の言語設定,日本語表示時の形態素区切り表示について業者に指示入れ。

・11/15 進捗報告。日本語表示エラーの改善中。当方よりの指示。(BCCWJ準拠)

(短い文脈)KWIC表示 ・・・ 当該形態素を中心に前後20形態素(全体で40形態素)

(長い文脈)KWIC表示で当該行をクリックするとポップアップ

・11/22 限定データで結果が表示されるようになる

・品詞分析の基本的なシステムもほぼ完成

・今後の改善

・文字数の縮小ないし幅を広げて行のまたがりをなくする

・作品情報へのリンクの付与

・複数条件の重複指定

(10月)

・10/1 検索システムの導入画面(ベータ版)完成。ICNALEとログインを分岐。

10/5 文芸家協会に再度メールで督促

10/5 文芸家協会より返信あり。担当者退社ということで個別作家への挨拶状の転送については否定的な感触。取次不可なら一方ほしいと連絡。

10/13 システム業者に提出するデータ形式について確認依頼。

10/14 業者よりデータ提出の要請。日本語については形態素解析データを送信。

10/15 昨日より2種の英訳データにタグ付けを実施。

作業メモ

(1)Sketch Engineに個別ファイルは100まで送信可

(2)Sketch Engineの出力(vert)をコピーしてExcel上でペーストした場合,一部のデータのcsvがが壊れることが判明(ファイル後半部)。したがって次のファイルのヘッダ行が落ちる。

(3) 各種実験の結果,Excel→開く→UTF8指定してExcelに取り込むとうまくいくことがわかる。

(9月)

9/15 出版社の確認期限到来(支障の連絡はなし)

9/10 検索システム開発契約

_________________________________________

開発スケジュール

1・〜 9月末

→全体的な今回の追加ご要望に関するシステム側の設計と仕様の確定

→TOPページと、各種検索の一覧 / 詳細画面のレイアウトの構築

→HTML側でみられる状態まで。

2・〜10月前半

→プログラムは未完了だが画面は見られる状況に(フィードバックなど)

3・〜10月末

→画面を元にプログラム開始 〜 KWIC検索や、FreqGraph検索まで

4・〜12月中頃まで(おそらく前倒し可能)

→残りのCollocation、Wordlist、Keyword検索関連と全体含めたフィードバックの予定で進行。

____________________________________________

9/17 著者宛の手紙発送について日本文芸家協会に連絡(157人217作品→1人平均1.38本)

9/20 JAECS論文の微修正

9/22 JAECSプロシ―を公開

9/22 文芸家協会に状況確認の督促メールを発送

9/23 検索システムについてエントリページのデザインを作成・業者に発送

9/24 切り分けを再度要請。対応の返事あり。

9/29 文芸家協会にTelするがテレワーク中でTel対応中止中とのこと。再度フォームより連絡を入れる。JAECS発表用のパワポ作成,発表ビデオ撮影。

(8月)

8/1 7/31作業にミスを発見。MNでの英訳時に,2001SN4と2001SN6を処理すべきところ,2021SN4と2021SN6を処理していた。→新規に2001のSN4とSN6をMNで処理し,MNフォルダに上書き

8/3 2011モジュールが納品。会計処理。

8/6 ICNALEの検索システムをベースに検索のモックイメージを作成。業者に送付し,見積もり依頼をとる。

8/10 開発業者とのメール質疑

8/10 Sketch Engineでタグ付け。vertファイルを個別にDLすることができなくなっていることを確認。開発業者に連絡。DLできないのは仕様とのこと。

(サポートの回答)

It is not possible in the interface. The solution would be for you to download the whole corpus and then split it to separate files by simple command in the command line, which could for example look something like this: csplit name_of_the_file_with_whole_corpus.txt '/doc id/' '{*}' .

8/11 開発業者とのZoom会議(1000~1020) 英語のPOS解析データについて,前回システムと同等での提供が可能であることを確認。

8/12 研究室で作業。2011データの英訳作成,形態素解析データ作成。日本語形態素データの統合エクセルを修正(v2に)。連番のふりなおし,年号列,雑誌名列を新設。

群像(GZ)がGNとなっていたエラーを修正。あわせて,年代別に品詞列のデータと形態素列のデータを作成。品詞については最初の列にA-B-Cの形で情報が付与されている。Antconcでは記号を認識する設定にしないとまとめて処理できない。形態素についても,アメリカ-america,私-代名詞のように意味確定(disambiguation)のためのタグがついているのでAntconcでは同様の処理が必要。JAECS論文用に,高頻度助詞を用いた分類を試行。

※1961~1991のかたまりと,2001~2021のかたまりにわかれる。作家が世紀の分かれ目を意識したというわけではもちろんないだろうが,助詞使用は世紀の切れ目でちょうど質的に変化している可能性がある。

8/13 JAECS用の予稿論文を執筆。

8/14 上記をいちおう完成(8p)。

8/16 上限が6pであることに気づき,修正作業。内容を圧縮して6pに。(1か月ほど寝かして再チェックして投稿予定)

8/17 各出版社への通知文を作成。また作品台帳をアップデート。各社への引用作品リスト送付の準備を行う。1700 発送完了。

8/20 システム開発業者より見積もり遅延の通知。

8/21 研究ネタメモ:「日本語学習者の作文の文体は教科書が執筆された年代の文体に影響されているのではないか?」調査

8/24 新潮社より確認通知をいただく。

(7月)

7/5

・1981-新潮/文学界/群像を借りだして複写

・自宅で1971の3セット,1981の3セットをスキャン

・現時点のデータの構造(3文芸誌,太字はテキスト化済)1961/1971/1981/1991/(未2001)/(未2011)/2021

・英語化について再検討:Deep L翻訳は訳せるところはこなれた良い翻訳になるが,一方で,同じ原文に対して表現の異なる訳が複数列挙されていたり(訳文a,訳文b,訳文cなどが並ぶ),原文の訳し飛ばしが非常に多い

・人手翻訳が理想だが,editageに翻訳させると5000字で65,000円(13円/字)。1年あたり30本として200万弱(3年600万)なので,これは予算的に不可。

・Deep L翻訳とGoogle翻訳(訳は不自然だが飛ばしはしない)を両方使う? NICTの「みんなの翻訳」に登録。テストデータで出力実験。

7/7

・1981年データ(B16/ G12/ S15=43件)より12本を削除(コードは元表記)→31本

(c)他の年代(1回)と重複している作家のうち,Bの掲載分を削除(3本)

81-B-03(芝木好子)

→以上を除去した場合,B=12,G=8, S=11,全体30となる。

※削除対象12本リスト

・1971/1981データの書き起こしを発注(作業1か月程度)

・Google翻訳でUKデータの日本語訳作業を行ったが17本で受け付けられなくなる・

'Are you sure you're quite fit? It's terrible weather. ' He turned round to face his colleague. For some esoteric reason Fairbanks always completed the buttoning of his flies in the main area of the lavatory. 'Good morning, Harold, ' he said. 'I'm pretty chipper, thanks, considering. '

【DeepL翻訳】

【日本語原文(2021-BG-01冒頭】

今日はおれの誕生日だった、おれは十七歳になった、セヴンティーンだ。家族のものは父も母も兄も皆な、おれの誕生日に気がつかないか、気がつかないふりをしていた。それで、おれも黙っていた。夕暮に、自衛隊の病院で看護婦をしている姉が帰ってきて、風呂場で石鹸を体じゅうにぬりたくっているおれに、《十七歳ね、自分の肉をつかんで見たくない?》といいにきた。

Today was my birthday, I turned seventeen, I'm a seventeen year old. Everyone in my family, my father, mother, and brother, either didn't know it was my birthday or pretended not to. So I kept quiet about it. At dusk, my sister, who worked as a nurse at a Self-Defense Forces hospital, came home and asked me, "You're seventeen, don't you want to grab your own flesh and see what it looks like?

・基本指標について60年間の増減を調査

・図書館で下記の2点について2月号の次号連載冒頭を補充入力

21-G-07 【3653/ 3617字】硝子万華鏡(第4回)→2月号から約1400字補填

7/13

・同年で2つ入っているのは吉行淳之介と小島信夫

・どちらかを落とす根拠がないので50音順で小島の1つを落とす(長短編バランスから連載のほうを残す)

・1971年版のDeepL英訳作成作業完了

・同上のみんなで翻訳英訳作成作業完了

21-G-07 【3653/ 3617字】硝子万華鏡(第4回)→2月号から約1400字補填

・DeepL訳,みんな訳,web茶豆,の3点セット処理。形態素台帳の旧データを削除して新データで差し替え。全体をソートしてsequence numberを割り付け。

・作品台帳の欠損データ(開始ページ数)を補填,連載にコードを付与,連載の連番表記を統一

・1981年版が納品。即日支払い処理完了。

・1981年版について2種の英訳を作成。

・1981年版について形態素データを作成。

「1961-2021日本語小説コーパス」の構築:日英小説対照研究の新しい可能性

"1961-2021 Japanese Fiction Corpus" : For a New Comparative Study of Japanese/ English Fictions

構築中の「1961-2021日本語小説コーパス」について報告する。これはBrown Corpusの標本抽出年である1961年を起点として,2021年まで,10年ごとの間隔で3大文芸誌(「新潮」「文学界」「群像」)に掲載された日本語の小説とその英訳(機械翻訳2種)を収集するものである。本コーパスは,60年間にわたる日本語の表記・表現・文体の変化の研究に活用できる。また,付随する英訳データをBrown/ LOB(1961年),Frown/

FLOB(1991年),Crown/ CLOB(2009年)等に収集されている小説データと対照させることで,時代要因を統制した上で,日本語小説と英米小説に出現するイメージ・比喩・マインドスケープの比較研究も可能になる。発表では本コーパスの開発理念と手順,また,収集済みのデータから明らかになった知見の一部を報告する。

(参考文献)

Leech, G., & Short, M. (2007) Style in Fiction (2nd Ed.). Routledge.

日本文体論学会(編)(1991)『文体論の世界』三省堂.

中村明(2016)『日本語文体論』岩波書店.

__________________________________________________________

7/27

・2001納品。英訳2種,形態素データを作成。

・作業後,SN-04~08に★が残っていることを確認→木曜に研究室で現物確認する。

7/29

・研究室で現物からページ中央のカゲの部分を追加入力(SN-04~08)

7/31

・追加した5本について,英訳2種作り直し,形態素とりなおし,形態素台帳のデータ差し替え。

A 同一人物が2回,3回エントリーしている例がある

B 米国作家の翻訳は1例含まれる

・DeepL proに登録

・英語コーパスの整形

(2) その後,=RIGHT(A1,LEN(A1)-8)式でコードを削除したセルを作成(上記の青)

(3) その後,コーパスごとの独自記号などを調査して可能な範囲で削除

6/16

・4コーパスのデータクリーニング継続

・センテンス途中の改行を削除(\n→φ)

・そのほか目視で見つかった文字化け,wonユt ('t),.モ (文末標識?)を修正

・邦文制作作業終了(29*4=116本)

6/18

・仮称 EJ-PARAFIC (English-Japanese Parallel Fiction Corpus)

・分析例

6/21

6/22

(1) 「言語から見た日米マインドスケープ比較」

→機械翻訳による対訳データを用いたパラレル比較

6/28

・図書館で1971年刊行雑誌を借りだし。

文学界:コピー完了

群像:1月号なし→文学部から取り寄せ依頼。

6/29

・2021データの打ち込みが納品(※3本が5000字に不足,対応検討)

21-G-03.txt(4,473字)

21-G-07.txt(3,653字)

21-S-11.txt(4,941字)

5/4 データ入力作業の外注にかかる謝金の調査

5/6 2020年度の科研報告

・「文学」でフィルタしても,いわゆる小説はほとんど存在しない

・文芸雑誌の所蔵状況を調査(すばるは1970年より,群像はさらに古いものも)

・文芸雑誌を母集団にする方向を検討

・新潮1961/1991を外部業者(熊本,Plain社)に入力委託(ページの真ん中は飛ばす指示で。各5000字。OCRを使わず手打ちをしていただく。旧かななどは新かな変換を依頼)

5/24

・新潮のページの境界の入力漏れの箇所を研究室で現物確認して補填

5/31

・群像1961にはコピーミスが確認されたので研究室で再度コピーのやり直し

・研究室で群像1961のコピー不足分,および,文学界の1961/1991をコピー

3/30

・2020年度の会計執行状況の確認(※コロナ影響で支出が予定通りできなかった)

2/15

・コーパス文体論の先行研究の調査

10/5

・内定にかかるオンライン手続きなど

...............................................................................................